问题背景:

近年来,随着计算能力的大幅提升和数据的极大丰富,以深度神经网络(DNN)为代表的AI技术,取得了长足的进步,在计算机视觉、语音、自然语言处理、游戏对弈等方面表现出超越或接近人类的能力。尽管与人们所理解的 “智能” 还有相当遥远的距离,但作为各种数据之间复杂关系的模型函数,DNN的成功已经受到广泛的关注。然而,DNN在成功的同时也面临着很多质疑,主要由于它仍是一个“黑盒”,这种状况已经严重阻碍了 DNN技术的继续发展和应用落地。现代社会的技术基础是千百年来形成的高度可解释的科学知识体系,现代生活方式已经无法容忍“炼金术”式的技术。例如,通信、医疗、自动驾驶等领域都要求高度透明、高度可靠的底层技术。以DNN为代表的AI技术必须解决可解释性问题,才能健康向前发展。

问题定义:

DNN的可解释性可以分为两类。一类是对于一个给定的DNN模型,对它的输入输出关系进行解释,即根据输入的特征对输出结果给出解释,目的是使输出结果合理化,这类解释通常面向AI产品的非专业使用者。另一类是从(数学)理论的角度解释DNN在使用中表现出的种种现象,例如其有效性,这类解释通常面向AI研究人员。这两类解释并不是互相独立的,只是侧重点有所不同。我们这里主要关注后一种意义上的解释,特别是对DNN的“黑盒”问题的理论解释。

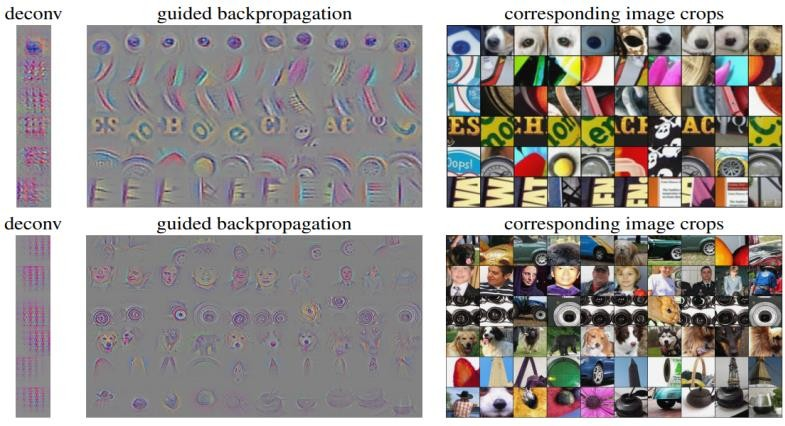

图 1:卷积神经网络中卷积层特征的可视化

DNN 的 “黑盒” 问题主要表现为: 在模型的设计与它在特定任务上的最终表现之间存在着未知的巨大鸿沟,人们无法在设计模型时对它的表现进行预估和精确控制,无法准确地理解它表现好或不好的原因,也没有一套系统化的手段提升它的表现,而只能“碰运气”。其根本原因在于,人们对任务(包括数据)和DNN模型的本质缺乏理解。

人们尝试从多个角度对DNN进行 “解释”,例如模型参数和提取特征的可视化分析(参见图1),借助简单的可解释模型等。这些方法帮助人们对DNN有了更多的了解,但距离DNN可解释性还有很大的差距。

从机器学习的角度来看,DNN作为数据之间复杂关系的模型函数,有三个基本方面: 模型的表示能力、模型的训练优化以及模型的泛化性能。遗憾的是,这三个方面都还没有得到透彻的理解。

模型的表示能力是指用DNN表示数据之间关系的能力,传统上属于函数逼近论的研究内容。目前,人们对DNN在经典函数空间(例如Sobolev空间)上的表示能力有了较好的理解。但实际的数据集与经典函数空间相去甚远,人们对实际数据空间还缺乏了解,更不用说DNN在这些空间上的表示能力了。

训练是通过优化模型参数,使模型能够较好地描述给定的数据集上定义的函数关系,这通常被表示为一个优化问题。但由于数据集和模型的复杂性,这个优化问题的目标函数也很复杂,而且通常是高维非凸优化问题。优化问题的特点和求解难度,归根结底是取决于目标函数的景观的特点,例如凸性、各种类型平衡点的分布等;后续简称景观特点。在DNN的训练问题中,人们对目标函数的景观特点知之甚少,更不用提针对其景观特点而设计的优化算法。但在一些具体任务中,人们使用随机梯度下降法(SGD)及其改进版能够得到较好的解。对于这些算法成功的原因有一些研究(例如过参数化),但对整个训练问题的理解还远远不够透彻。

泛化是指在有限样本数据集上训练得到的模型能够对数据空间全体样本有效。训练数据集的规模大小和代表性还是一个开放问题,特别是在DNN中参数数量超过数据量而不出现过拟合的现象还没有得到透彻的解释。但一些启发式的推理使我们相信数据空间是某种低维分布,因此通常的数据量可能是足够的。另一方面,DNN何以能够自动地利用这种低维结构来避免过拟合,这也是开放的问题。

未来研究方向:

关于DNN可解释性问题,如下方向值得进一步研究:

(1)发展大数据科学理论和工具,深入挖掘和准确刻画特定类型数据空间的结构,如自然图像空间特征;

(2)针对这些具体的数据空间研究DNN的函数表示能力;

(3)研究DNN训练优化问题中目标函数的景观特点,并针对这种特性设计优化算法;

(4)对DNN避免过拟合的机制给出可信的解释。